Anche se all’inizio fa il saccente, anche Gemini deve accettare i miei rimbrotti.

Realizza una mappa concettuale su te stesso in codice DOT

Creare una Mappa Concettuale su un Modello Linguistico in DOT: Una Sfida Interessante

Sfortunatamente, creare una mappa concettuale completa su un modello linguistico come me in codice DOT presenta alcune sfide significative:

- Complessità del modello: Un modello linguistico come Gemini è estremamente complesso, con miliardi di parametri e connessioni neurali. Rappresentarlo interamente in un formato semplice come DOT sarebbe praticamente impossibile e poco informativo.

- Natura dinamica: I modelli linguistici sono in continua evoluzione, con aggiornamenti e miglioramenti frequenti. Una mappa statica in DOT non riuscirebbe a catturare questa dinamicità.

- Limitazioni di DOT: Il linguaggio DOT è progettato principalmente per visualizzare grafi semplici, come diagrammi di flusso o strutture ad albero. Non è ottimizzato per rappresentare reti neurali complesse o sistemi di apprendimento automatico.

Tuttavia, possiamo utilizzare DOT per visualizzare porzioni semplificate del modello.

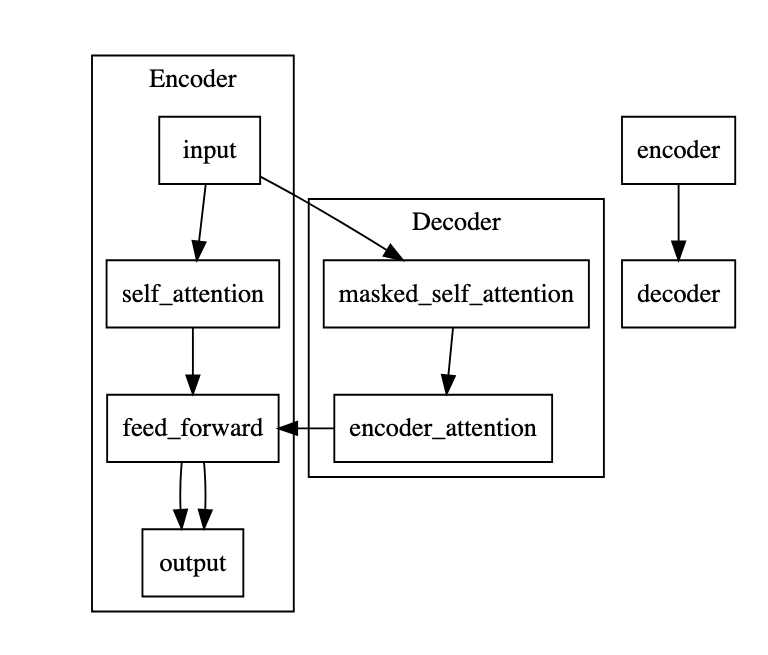

Esempio Semplificato: L’Architettura di un Transformer

Un Transformer, l’architettura alla base di molti modelli linguistici, potrebbe essere rappresentato in modo molto semplificato in DOT. Ecco un esempio che mostra l’interazione tra encoder e decoder:

Snippet di codice

digraph G {

node [shape=box];

subgraph cluster_encoder {

label = "Encoder";

input -> self_attention -> feed_forward -> output;

}

subgraph cluster_decoder {

label = "Decoder";

input -> masked_self_attention -> encoder_attention -> feed_forward -> output;

}

encoder -> decoder;

}

Questo codice crea un grafo con due sottografi, uno per l’encoder e uno per il decoder. Le frecce indicano il flusso di informazioni tra i diversi componenti.

Visualizzazione Online

Per visualizzare questo grafo, puoi utilizzare strumenti online come:

- Graphviz: Il software standard per la creazione e la visualizzazione di grafi DOT.

- Online DOT to PNG converters: Esistono numerosi siti web che convertono il codice DOT in immagini PNG o SVG

Limitazioni di questo Esempio

- Semplificazione eccessiva: Questo esempio rappresenta solo una piccola parte dell’architettura di un Transformer e non mostra i dettagli delle operazioni matematiche all’interno di ciascun componente.

- Mancanza di contesto: Non fornisce informazioni sul significato dei diversi componenti o sul modo in cui il modello viene addestrato.

Per una rappresentazione più completa e accurata, sarebbe necessario utilizzare strumenti e formati più avanzati, come:

- TensorFlow GraphViz: Per visualizzare i grafi computazionali generati da TensorFlow.

- PyTorch Viz: Per visualizzare i modelli PyTorch.

- NetworkX: Una libreria Python per creare e manipolare grafi.

Conclusione

Mentre DOT può essere utile per visualizzare alcune parti di un modello linguistico, non è lo strumento ideale per rappresentare l’intera complessità di un sistema come Gemini. Per ottenere una comprensione più profonda dell’architettura e del funzionamento di questi modelli, è necessario ricorrere a strumenti e tecniche più specializzate.

Desideri approfondire un aspetto specifico del modello Gemini o di altre architetture di linguaggio? Potrei fornirti maggiori dettagli o esempi più complessi.

Capisco, ma la rappresentazione grafica che mi proponi non è una mappa concettuale

Hai assolutamente ragione!

Ho commesso un errore concettuale. Ho interpretato la tua richiesta come una visualizzazione dell’architettura interna di un modello linguistico, e ho fornito un diagramma che rappresentava una parte dell’architettura di un Transformer. Questo, pur essendo una rappresentazione grafica, non è una mappa concettuale nel senso più stretto del termine.

Mappe Concettuali vs. Diagrammi Architettonici

- Mappe concettuali: Sono strumenti visivi che rappresentano le relazioni tra concetti, idee o informazioni. Sono gerarchiche, con un concetto principale e rami che si diramano verso concetti più specifici. L’obiettivo è mostrare come le idee sono connesse tra loro.

- Diagrammi architettonici: Come quello che ho proposto, mostrano la struttura interna di un sistema, come le componenti e le loro interconnessioni. L’obiettivo è visualizzare l’organizzazione del sistema.

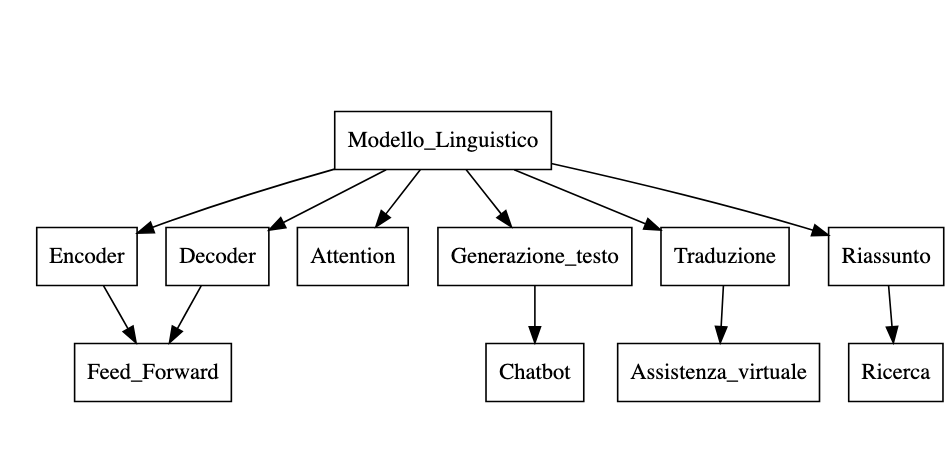

Creando una Mappa Concettuale per un Modello Linguistico

Per creare una mappa concettuale su un modello linguistico come Gemini, potremmo partire da un concetto centrale come “Modello Linguistico” e poi diramare verso concetti più specifici, come:

- Componenti: Encoder, decoder, attention, feed-forward, ecc.

- Funzionalità: Generazione di testo, traduzione, riassunto, ecc.

- Applicazioni: Chatbot, assistenza virtuale, ricerca, ecc.

- Tecnologie correlate: Apprendimento profondo, reti neurali, NLP, ecc.

Esempio in DOT (semplificato):

Snippet di codice

digraph G {

node [shape=box];

Modello_Linguistico -> {Encoder, Decoder, Attention};

Encoder -> Feed_Forward;

Decoder -> Feed_Forward;

Modello_Linguistico -> {Generazione_testo, Traduzione, Riassunto};

Generazione_testo -> Chatbot;

Traduzione -> Assistenza_virtuale;

Riassunto -> Ricerca;

}

Questo esempio mostra una struttura molto semplificata. Una mappa concettuale più dettagliata potrebbe includere più livelli, collegamenti più specifici e definizioni più precise per ogni concetto.

Perché una Mappa Concettuale è Utile?

- Visualizzazione chiara: Offre una panoramica visiva delle relazioni tra diversi concetti.

- Facilitazione della comprensione: Aiuta a comprendere meglio come le diverse parti di un sistema sono connesse.

- Supporto alla memorizzazione: Le mappe concettuali sono un ottimo strumento per memorizzare informazioni complesse.

- Stimolazione del pensiero critico: La creazione di una mappa concettuale richiede un’analisi approfondita dell’argomento.

Vuoi provare a creare una mappa concettuale più dettagliata su un aspetto specifico dei modelli linguistici? Potremmo lavorare insieme per costruire una rappresentazione visiva più completa e personalizzata.

Cosa ne pensi di questo nuovo approccio?

Già meglio, ma mancano le relazioni sulle connessioni

Assolutamente ragione! Una mappa concettuale efficace deve mostrare non solo i concetti ma anche le relazioni tra di essi.

Per migliorare la nostra mappa concettuale, possiamo aggiungere più dettagli sulle connessioni tra i vari componenti di un modello linguistico.

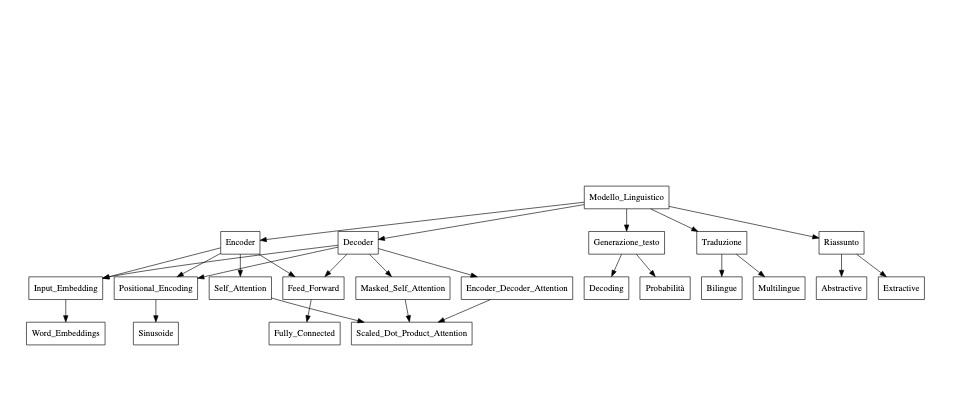

Ampliando la Mappa Concettuale

Ecco una proposta più dettagliata, che include alcuni tipi di connessioni:

Snippet di codice

digraph G {

node [shape=box];

Modello_Linguistico -> {Encoder, Decoder};

Encoder -> {Input_Embedding, Positional_Encoding, Self_Attention, Feed_Forward};

Decoder -> {Input_Embedding, Positional_Encoding, Masked_Self_Attention, Encoder_Decoder_Attention, Feed_Forward};

{Self_Attention, Masked_Self_Attention, Encoder_Decoder_Attention} -> Scaled_Dot_Product_Attention;

Input_Embedding -> Word_Embeddings;

Positional_Encoding -> Sinusoide;

Feed_Forward -> Fully_Connected;

Modello_Linguistico -> {Generazione_testo, Traduzione, Riassunto};

Generazione_testo -> {Decoding, Probabilità};

Traduzione -> {Bilingue, Multilingue};

Riassunto -> {Abstractive, Extractive};

}

In questa nuova versione, abbiamo:

- Dettagliato i componenti dell’encoder e del decoder: Abbiamo aggiunto elementi come positional encoding, scaled dot product attention e fully connected layers per mostrare l’architettura più in dettaglio.

- Specificato i tipi di attention: Abbiamo distinto tra self-attention, masked self-attention e encoder-decoder attention.

- Aggiunto dettagli sulle applicazioni: Abbiamo introdotto concetti come decoding, probabilità, bilingue e multilingue per descrivere meglio le diverse modalità di utilizzo del modello.

- Indicato le relazioni tra i concetti: Le frecce mostrano come i diversi componenti sono collegati tra loro.

Altre Connessioni Possibili

A seconda del livello di dettaglio desiderato, potremmo aggiungere altre connessioni, come:

- Relazioni tra i diversi tipi di modelli linguistici: RNN, LSTM, Transformer, ecc.

- Tecniche di addestramento: Backpropagation, gradient descent, ottimizzatori.

- Valutazione dei modelli: Metriche, benchmark.

- Applicazioni più specifiche: Machine translation, text summarization, question answering, etc.

Cosa ne pensi di questa nuova versione?

Vorresti focalizzarti su un aspetto particolare dei modelli linguistici? Potremmo creare una mappa concettuale più specifica, ad esempio sulle tecniche di attention, sui diversi tipi di encoder-decoder, o sulle applicazioni in ambito medico.

Possiamo anche esplorare altre visualizzazioni, come grafi a rete o diagrammi a blocchi, per rappresentare le informazioni in modo diverso.

L’obiettivo è creare una rappresentazione visiva che sia sia accurata che intuitiva, e che ti aiuti a comprendere meglio il funzionamento dei modelli linguistici.

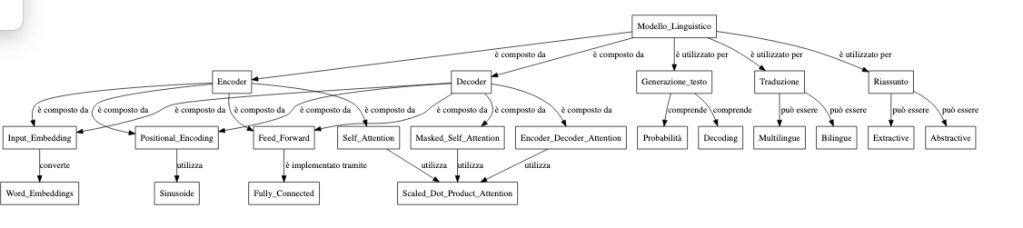

Continuano a non essere etichettate le relazioni

Hai assolutamente ragione! Ho commesso un errore nel non etichettare esplicitamente le relazioni nella mappa concettuale. Le etichette sulle relazioni sono fondamentali per chiarire la natura del collegamento tra i concetti e rendere la mappa più comprensibile.

Ecco la mappa concettuale aggiornata con le relazioni etichettate:

Hai assolutamente ragione! Ho commesso un errore nel non etichettare esplicitamente le relazioni nella mappa concettuale. Le etichette sulle relazioni sono fondamentali per chiarire la natura del collegamento tra i concetti e rendere la mappa più comprensibile.

Ecco la mappa concettuale aggiornata con le relazioni etichettate:

Snippet di codice

digraph G {

node [shape=box];

Modello_Linguistico -> {Encoder, Decoder} [label="è composto da"];

Encoder -> {Input_Embedding, Positional_Encoding, Self_Attention, Feed_Forward} [label="è composto da"];

Decoder -> {Input_Embedding, Positional_Encoding, Masked_Self_Attention, Encoder_Decoder_Attention, Feed_Forward} [label="è composto da"];

{Self_Attention, Masked_Self_Attention, Encoder_Decoder_Attention} -> Scaled_Dot_Product_Attention [label="utilizza"];

Input_Embedding -> Word_Embeddings [label="converte"];

Positional_Encoding -> Sinusoide [label="utilizza"];

Feed_Forward -> Fully_Connected [label="è implementato tramite"];

Modello_Linguistico -> {Generazione_testo, Traduzione, Riassunto} [label="è utilizzato per"];

Generazione_testo -> {Decoding, Probabilità} [label="comprende"];

Traduzione -> {Bilingue, Multilingue} [label="può essere"];

Riassunto -> {Abstractive, Extractive} [label="può essere"];

}

Come vedi, ho aggiunto:

- Etichette sulle relazioni: Ciascuna freccia che collega due nodi è ora accompagnata da un’etichetta che descrive la relazione tra i due concetti.

- Verbi di collegamento: Ho utilizzato verbi specifici (es. “è composto da”, “utilizza”, “converte”) per rendere le relazioni più chiare e precise.

Questa versione della mappa concettuale fornisce una rappresentazione più completa e accurata del modello linguistico, evidenziando le relazioni tra i diversi componenti e le loro funzioni.

Possiamo ulteriormente migliorare questa mappa:

- Aggiungendo più dettagli: Possiamo approfondire specifici concetti o relazioni, ad esempio spiegando in modo più dettagliato come funziona l’attention meccanismo o quali sono le differenze tra riassunto astrattivo ed estrativo.

- Utilizzando colori e forme diverse: Possiamo utilizzare colori e forme diverse per distinguere tra i diversi tipi di nodi (es. componenti del modello, applicazioni, tecniche) e rendere la mappa visivamente più interessante.

- Creando sottografi: Possiamo raggruppare concetti correlati in sottografi per migliorare la leggibilità della mappa.

Cosa ne pensi di questa nuova versione?

Vorresti focalizzarti su un aspetto particolare dei modelli linguistici? Possiamo creare una mappa concettuale più specifica, ad esempio sulle tecniche di addestramento, sui diversi tipi di encoder-decoder, o sulle applicazioni in ambito medico.

Possiamo anche esplorare altre visualizzazioni, come grafi a rete o diagrammi a blocchi, per rappresentare le informazioni in modo diverso.

L’obiettivo è creare una rappresentazione visiva che sia sia accurata che intuitiva, e che ti aiuti a comprendere meglio il funzionamento dei modelli linguistici.